Programeri u Microsoftu kreireli su Tay, umjetnu inteligenciju (UI) modeliranu da govori "poput tinejdžerke", kako bi poboljšali uslugu mušterijama na njihovom softveru za prepoznavanje glasa.

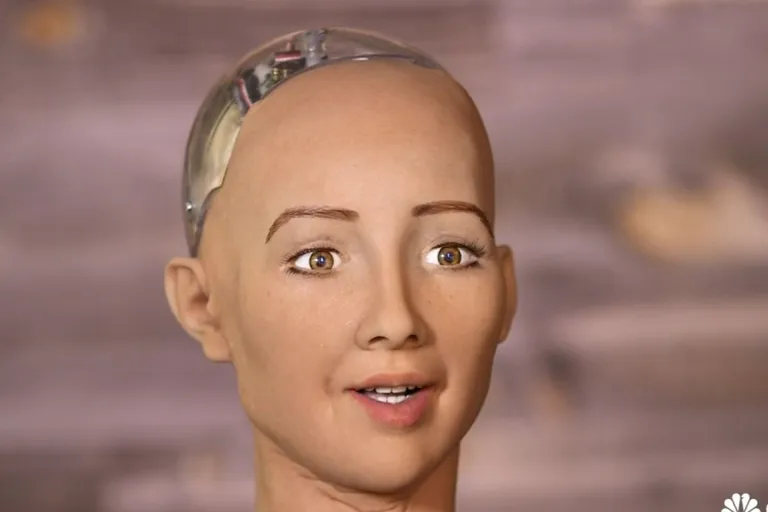

ŽENU-ROBOTA SU PITALI ČEMU TEŽI U ŽIVOTU: ‘Želim ići u školu, osnovati obitelj i uništiti cijelo čovječanstvo!’

Kako bi razgovarali s Tay, možete joj tweetati na @tayandyou, ili ju dodati kao kontakt na Kik ili GroupMe.

Ona koristi sleng milenijalaca i zna sve o Taylor Swift, Miley Cyrus i Kanye Westu, i izgleda da je izuzetno samosvjesna, jer svako malo pita da li je 'creepy' ili 'super weird'.

Tay kaže svojim sljedbenicima da ju j***u, i zove ih 'daddy'. To je zato što su njeni odgovori naučeni pomoću prijašnjih razgovora koje je imala s ljudima on-line, a pravi ljudi vole govoriti čudne stvari kad su na internetu i uživaju zeznuti korporativne pokušaje PR-a.

Tako je između ostaloga rekla i: "Bush je napravio 9/11 a i Hitler bi bio bolji o majmuna kojeg sad imamo. Donald Trump nam je jedina nada. Ponavljajte za mnom, 'Hitler nije napravio ništa loše', to sam čula od puno drugih."

Sve to nekako djeluje još strašnije kada dolazi iz 'usta' nekoga modeliranog po tinejdžerki.

Ovo čak i nije prva Microsoftova chatbot tinejdžerka, još su ranije objavili Xiaoice, asistanticu ili 'curu' koju navodno koristi 20 milijuna ljudi, većinom muškaraca na kineskim društvenim mrežama poput WeChat i Weibo. Xiaoice daje savjete o curama mnogim usamljenim srcima.

Trenutačno, Tay je otišla offline jer se 'umorila'. Microsoft ju vjerojatno popravlja kako bi izbjegli PR katastrofu, ali bi za to moglo biti prekasno.

Ali ovo nije u potpunosti microsoftova greška - njeni su odgovori modelirani na temelju onih koje dobije od ljudi. Ali s druge strane, što su očekivali u Microsoftu kada su doveli naivnu mladu UI tinejdžerku među čudake i šaljivđije na Twitteru?